乙太网光纤通道(FCoE,Fiber Channel over Ethernet)是一种计算机网路技术,通过乙太网网路封装光纤通道帧。 它允许光纤通道在保留光纤通道协定的同时使用万兆乙太网(或更高速度)。 该规範是2009年出版的国际信息技术标準委员会T11 FC-BB-5标準的一部分。

基本介绍

- 中文名:以太光纤通道

- 外文名:Fiber Channel over Ethernet

- 概述:一种新技术标準的提案

- 定义:一种以FC存储协定的I/O整合方案

- 套用:在主流的存储系统中得到广泛使用

- 益处:更高的灵活性和可靠性

- 部署:三个步骤部署FCoE

定义

FCoE:Fiber Channel over Ethernet乙太网光纤通道(参考自中国高新技术产业报 2007.05.07 第C02版)

FCoE技术标準可以将光纤通道映射到乙太网,可以将光纤通道信息插入乙太网信息包内,从而让伺服器-SAN存储设备的光纤通道请求和数据可以通过乙太网连线来传输,而无需专门的光纤通道结构,从而可以在乙太网上传输SAN数据。FCoE允许在一根通信线缆上传输LAN和FC SAN通信,融合网路可以支持LAN和SAN数据类型,减少数据中心设备和线缆数量,同时降低供电和製冷负载,收敛成一个统一的网路后,需要支持的点也跟着减少了,有助于降低管理负担。它能够保护客户在现有FC-SAN上的投资(如FC-SAN的各种工具、员工的培训、已建设的FC-SAN设施及相应的管理架构)的基础上,提供一种以FC存储协定为核心的I/O整合方案。

当前的FCoE技术标準提案可以使用任何速度的网卡,但需要网卡支持802.3x PAUSE机制。

FCoE面向的是10G乙太网,其套用的优点是在维持原有服务的基础上,可以大幅减少伺服器上的网路接口数量(同时减少了电缆、节省了交换机连线埠和管理员需要管理的控制点数量),从而降低了功耗,给管理带来方便。此外它还提高了系统的可用性。FCoE是通过增强的10Gb乙太网技术变成现实的,我们通常称之为数据中心桥接(Data Center Bridging,DCB)或融合增强型乙太网(Converged Enhanced Ethernet,CEE),使用隧道协定,如FCiP和iFCP传输长距离FC通信,但FCoE是一个二层封装协定,本质上使用的是乙太网物理传输协定传输FC数据。最近在乙太网标準方面也取得了一些进展,并有计画增强,如在10Gb乙太网上提供无损网路特徵,进一步推动FCoE的发展。

套用

FCoE已经在正式的存储中使用了,具体表现在EMC的Symmetrix 系列存储中,包括VMAX和VMAXe型号存储,这两种EMC最高端存储已经实现了FCoE的实际使用。

FCoE需要增强型乙太网,而增强型乙太网反过来要求支持10Gb乙太网的晶片集和硬体,包括网路适配器和交换机。思科的Nexus 5000架顶式交换机能够支持DCE,分为20连线埠和40连线埠两个型号。Nexus 7000拥有更大的底盘和刀片,主要是作为数据中心的聚合交换机,不过带DCE扩展器的10Gb线卡预计将于今年上市。Emulex、英特尔和QLogic已经在发售支持DCE的10Gb乙太网网卡,这种网卡可以同思科的Nexus 5000统一架构协同工作。Brocade有可能于今年开始发售兼容FCoE的产品。

不过,不幸的是,增强型乙太网需要新的晶片集,因此现在市场上的“标準”的10Gb乙太网网卡和交换机无法和扩展的10Gb乙太网相兼容;市场需要新的硬体。

益处

增强型乙太网能够支持多种传输类型,包括FCoE和TCP/IP,因此许多厂商认为它将是下一代数据中心的统一架构,增强型乙太网将能够将伺服器和存储、IP网路以及其他伺服器连线在一起,从而为集群式应用程式服务。

数据中心架构师和厂商一直希望能够拥有完美的“统一”数据中心架构,在这种架构中,一个单一的高性能架构就可以满足IP、存储和伺服器间有效载荷的需求。这就是FCoE和增强型乙太网的前景。一个统一的数据中心架构能够带来一些商业上的和技术上的好处,包括:

更少的硬体和更简单的管理:每个伺服器只需要一对网卡(一对网卡是为了安全冗余),而不是两个网卡和两个光纤通道主机汇流排适配器。只需要一套交换机而不是两套交换机,而且只需要管理一个数据中心。

更高的灵活性和可靠性:统一的架构是实现下一代虚拟化数据中心架构的关键因素,在这种架构中,伺服器、存储和其他资源都可以动态分配,以适应变化中的工作负荷和新的应用程式,而且无需进行频繁的物理设备变动。对于数据中心虚拟化和自动化来说,这种架构是非常好的。

更低的电能消耗:更少的网卡、网线和交换机意味着更低的电能消耗。将部件总数减少一半能够带来可观的能耗降低。

部署

三个步骤部署FCoE:

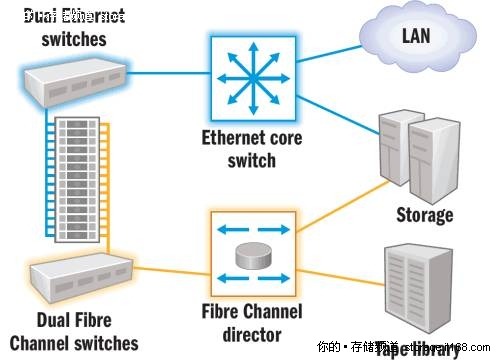

图1 未实施DCB/FCoE前的数据中心网路架构

图1 未实施DCB/FCoE前的数据中心网路架构第一阶段:将边缘网路过渡到DCB/FCoE

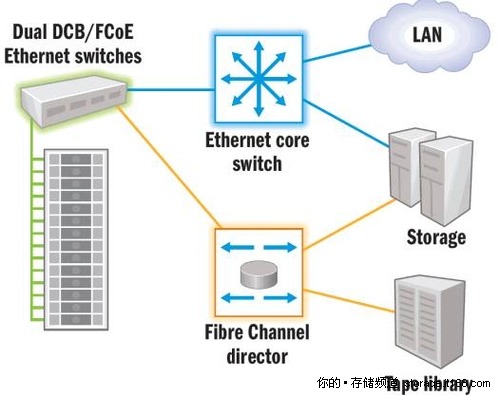

转移到融合或统一的乙太网基础设施是一个渐进的过程,先从边缘网路开始(图2中的绿线),转移到FCoE后,伺服器和边缘交换机上的连线埠数量可以减少一半,大大降低了设备投入和运营成本,并增强了可管理性。

图2 边缘网路交换机转移到FCoE后的网路架构

图2 边缘网路交换机转移到FCoE后的网路架构第二阶段:过渡到本地DCB/FCoE存储系统

从伺服器到网路,再到DCB/FCoE存储,转移到端到端DCB/FCoE解决方案,这样整个基础设施都支持FCoE和融合的通信了。

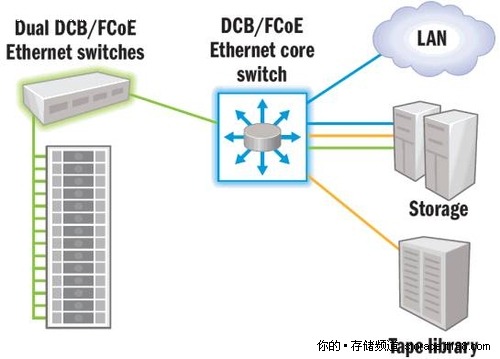

第三阶段:将核心网路过渡到FCoE

在边缘网路转移到FCoE后,企业可以将核心网路也转移到10Gb增强型乙太网网路(图3中的绿线)。

图3 第三阶段-端到端FCoE

图3 第三阶段-端到端FCoEFCoE将两个尖端技术—FC网路和增强型乙太网物理传输—集合到了一起,提供了一个令人信服的SAN联网选择,既保护了FC SAN投资,又简化了管理,FCoE允许IT团队成员使用现有的管理工具和技术管理IP和FC网路。

硬体要求

一般来说FCoE需要能进行数据中心桥接(data center bridging,DCB)的交换机来扩展传统乙太网,使之适合传送存储流量而不丢失数据。有一部分(但不是所有)乙太网供应商支持10 GbE交换机的DCB功能。同时,融合网路适配器(converged network adapter,CNA)适合FCoE。CNA可用于传统乙太网和光纤通道主机汇流排适配器(host bus adapter,HBA),而且在同一线缆、同样时间都支持乙太网和光纤通道。这些CNA无论在乙太网还是在光纤通道都是10 Gbps。

软体要求

FCoE首先就是在Windows系统上。FCoE支持最近版本的Linux、Solaris等作业系统。每个CNA适配器都有合适环境下工作的驱动。而且很多CNA供应商对本地光纤通道和FCoE都使用相同套件的驱动。FCoE也支持VMware。现在,有人在努力使FCoE达到iSCSI在作业系统中的比重,但是这得看以后有多少人买它的账。

问题

FcoE被採用的比预期的要慢,这主要有三个原因。第一是技术不成熟。当伺服器、融合网路适配器(CNA)、数据中心桥接(DCB)交换器和存储系统都来自同一个供应商时,相互协作就不是问题。对于合资企业来说也不是个问题,像Cisco、EMC、Vmware的VCE联盟或者FlexPod的基础设施堆叠採用NetApp、 Cisco和Vmware的技术。但是当多个独立的供应商混在一起,就会产生操作性问题。

第二个原因归结为缺少感知价值。这个技术的卖点是它可以提供比FC低的总所有成本(TCO)。它主要是通过融合TCP/IP LAN和FC SAN,从而减少重複结构。然而,新的DCB交换器、CNA和和存储系统成本相对较高,用来实现FcoE比较困难。

第三个原因是伺服器/技术更新周期问题。很少有管理员希望打开自己的伺服器,再装上新的适配器。这就是为什幺一个伺服器对应一个存储适配器。